(文/观察者网吕栋编辑/张广凯)配资门户平台

“算力是中国人工智能的关键,国内AI要多少算力就给多少算力,你要什么样的算力就给你什么样的算力。中国无论是谁想训练多大参数的大模型,都是有商业基础和算力提供的。”在刚刚结束的华为全连接大会上,华为轮值董事长徐直军对观察者网等媒体说道。

这次大会上,徐直军时隔六年再度公布昇腾和鲲鹏芯片的进展,让外界颇感意外。从华为披露的信息,我们可以得到两个确定性结论:一昇腾、鲲鹏两大计算芯片将持续演进;二包括昇腾在内的国产AI芯片,仍将受制于国内芯片工艺的落后,单卡性能或长期落后英伟达。

那国内的AI算力需求怎么被满足?徐直军向观察者网强调了华为“5个字”核心战略,就是“超节点+集群”,“AI算力不等于芯片性能,单颗芯片性能的短板可以通过‘超节点和集群’方式解决,且实现性能更强,同时国内的电力基础施优势也解决了算力用电问题。”

在当下,包括摩尔线程、壁仞科技、沐曦集成电路等初创GPU公司,已经纷纷表示兼容英伟达的CUDA计算生态,外界近期传出华为也可能调整战略,发展GPU并兼容CUDA。

但从徐直军的表态来看,昇腾兼容CUDA的传言并不可靠。他表示,华为要做开源开放的生态,不兼容CUDA是从长远考虑,“CUDA现在也不能随便用,都是过去的版本。如果哪天CUDA生态兼容不了怎么办?只要大家心往一处想,都来使用,国内生态一定会发展起来。”

芯片制程落后,昇腾单卡算力受限

这次大会,最受关注的莫过于华为再度公布昇腾芯片的技术进展,让外界能更直观地了解昇腾芯片的实力和未来规划,也让大家对国产AI算力有了更多底气。

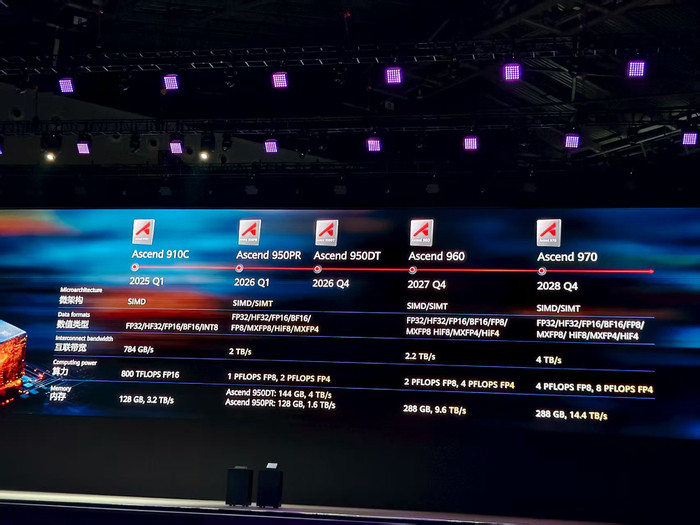

按照华为公布的信息,昇腾910C在今年一季度已推出,它的FP16(半精度浮点数)算力为800TFLOPS(每秒万亿次浮点运算,0.8PFLOPS),内存为128GB,带宽为3.2TB/s。

作为对比,英伟达“中国特供”H20芯片的FP16算力为148TFLOPS,内存为96GB,带宽为4TB/s;H100同等精度下的算力为990TFLOPS,内存为80GB,带宽为3.35TB/s。

简单对比就会发现,昇腾910C的FP16算力已是英伟达H20的5倍多,逼近H100。而在内存容量上,昇腾910C也超过了H20和H100,只是带宽还略有落后。

这或许就是中国监管敢于直接对H20“后门”问题出手的底气,毕竟昇腾910C的实力已不输于H20。但H20毕竟还是“阉割版”,与英伟达最先进的芯片相比,昇腾芯片的实力又如何呢?

以华为计划在2027年四季度推出的昇腾960芯片为例,它的FP8精度下算力为2PFLOPS,FP4精度下算力为4PFLOPS,内存容量为288GB,带宽为9.6TB/s。

作为对比,英伟达去年3月发布的B200芯片,FP8精度下算力为4.5PFLOPS(稠密模式,稀疏计算会更大),FP4精度下算力为9PFLOPS,内存容量为192GB,带宽为8TB/s。

不难看出,即便是两年后的昇腾960,在单芯片算力上与B200仍存在一倍的差距。

直到计划2028年四季度推出的昇腾970,它的FP8算力为4PFLOPS,FP4算力为8PFLOPS,显存容量为288GB,带宽为14.4TB/s,这些指标才能与B200一较高下。

昇腾已经是国产AI芯片的领跑者,其他芯片企业的单卡性能与英伟达存在更明显的差距。比如正在冲刺IPO的摩尔线程,它的MTTS5000计算加速卡在FP32精度下的算力为32TFLOPS,这个数据与H20的44TFLOPS比较接近,但只有H100的一半。

国产单卡的落后原因可能是多方面的,最关键的还是芯片制程,毕竟英伟达可以随意使用台积电的先进制程,购买更先进的HBM,而中国企业在制裁封锁下只能自力更生。

徐直军坦言,智能化的可持续,首先是算力的可持续。中国半导体制造工艺将在相当长时间处于落后状态,可持续的算力只能基于实际可获得的芯片制造工艺。

华为核心战略在5个字上,芯片之外都是优势

算力是全球人工智能发展的关键,已经是不争的事实。在美国持续封锁中国AI单芯片的大背景下,我们怎么才能获取更多算力,为AI产业提供支撑?

徐直军在全连接大会上对观察者网坦言,华为的核心战略就是“超节点+集群”,整个战略在这5个字上,“我们认为只有依靠超节点和集群,才能规避中国的芯片制造工艺受限,能够为中国的AI发展提供源源不断的算力支持和供给。”

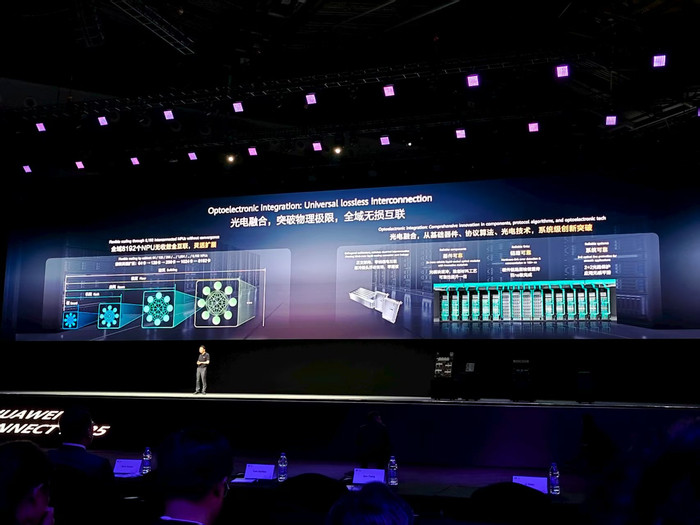

这次全连接大会上,华为公布了Atlas950超节点,它将在2026年四季度上市,由8192颗昇腾950DT芯片全光高速互联而成,是今年商用的CloudMatrix384超节点的20多倍,FP8算力达到8EFLOPS,FP4算力达到16EFLOPS,互联带宽达到16PB/s。

“单颗芯片相比较英伟达有差距,生态还有差距,但是做成超节点集群,我们有自信和底气。因为AI就是并行计算,所以我们的解决方案就是开创计算架构,基于灵衢互联协议打造超节点和集群,来满足我国无穷无尽的算力需求,这是我们对自己的目标,又是对产业界的承诺,更是对国家的承诺。”他说道。

徐直军表示,Atlas950超节点,至少在未来多年都将保持是全球最强算力的超节点,相比英伟达将在明年下半年上市的NVL144,Atlas950超节点卡的规模是其56.8倍,总算力是其6.7倍,内存容量是其15倍,达到1152TB;互联带宽是其62倍,达到16.3PB/s。即使是与英伟达计划2027年上市的NVL576相比,Atlas950超节点各方面依然领先。

超节点的本质还是堆卡,但又不是简单堆卡。以CloudMatrix384超节点为例,它是华为光通信、网络、供电等多种能力“大杂烩”的结果。更重要的是,它打破了传统以CPU为中心的冯诺依曼架构,凭借高速互联总线的关键突破,实现了更大的算力密度和互联带宽。

但超节点也会带来一个重要问题,就是功耗。按照海外机构SemiAnalysis发布的数据,华为CloudMatrix384超节点的算力是英伟达NVL72的1.7倍,功耗则达到了4.1倍。

在徐直军看来,这并非瓶颈。“超节点+集群有能力为中国AI产业提供充足算力,让中国没有算力之忧。但是功耗大一点,电要耗多一点,但无论怎么说,我们有(资源),而且我们国家电价相对便宜。除了单颗芯片比它的算力小一点,功耗大一点,其他都是优势。”

为什么华为不兼容CUDA生态?

在AI的大规模计算中,芯片能力固然很重要,但同样离不开软件的协同。以英伟达为例,它的GPU虽然性能强大,但仍然需要CUDA的协助,才能充分释放GPU的性能。

根据公开数据,目前英伟达CUDA闭源生态中已有500多万开发者,超过900个高性能库/框架,并且已连续迭代了18年。在当下,CUDA已不仅是编程框架,而是事实上的“AI计算操作系统”,竞争对手先得复制这18年的“代码+人才+习惯”沉淀,才敢谈替代。

也就是在这个背景下,包括摩尔线程、壁仞科技、沐曦集成电路等初创的国产GPU企业,率先发力兼容CUDA生态,并伺机发展自主生态,以向开发者提供更方便的使用体验。

但华为并没有像早期鸿蒙兼容安卓一样兼容CUDA,而是坚持发展CANN和MindSpore等全栈能力。

“为什么我们不兼容CUDA生态,一定要搞开源生态和MindSpore,也是为长远考虑的,我一直做,我投这么多钱兼容CUDA生态,而且CUDA现在也不能随便用,都是过去的版本。如果哪天CUDA生态兼容不了怎么办?为什么我还坚定不移搞一个MindSpore呢?当时专家都反对。我们的AI,从达芬奇到昇腾芯片到整个一切,包括所有的软件生态都不依赖于西方生态和供应链。所以长远来考虑的话,要把生态构建起来。”徐直军说道。

今年8月,华为宣布CANN编译器和虚拟指令集接口开放,其它软件全开源,CANN基于昇腾910B/C芯片的开源开放将于2025年12月31日前完成,未来开源开放与产品上市同步;Mind系列应用使能套件及工具链全面开源,并于2025年12月31日前完成;openPangu基础大模型全面开源。

“华为为什么做开源开放的生态?我们的进步是在和客户不断地交互过程中相互促进与进步的。说‘开源开放’这四个字是难啊,尤其是对华为这种成长型的公司,大家习惯把源代码捂得死死的,因为是核心资产,为此我们要说服大家到底从哪里挣钱。”徐直军坦言,华为的变现靠昇腾硬件,其他的一切都可以开源开放。开源开放是促进硬件规模和硬件的普遍使用,“大家都用了,我卖得多了,开源开放的钱就挣回来了。”

但现在华为有一个明显的挑战是,在训出准万亿参数的盘古UltraMoE大模型之后,怎么吸引更多像DeepSeek一样的外部顶级大模型在昇腾平台上训练,这样才能不断证明昇腾与英伟达的抗衡能力。

“国内AI企业用昇腾训练大模型,主要看是他们用不用,就像谈恋爱,不谈的话,你怎么知道对方的优缺点配资门户平台,合适不合适,你要谈一下,要用一下。在用的过程中有问题解决问题。当然了,第一是我们的生态和整个的工具链肯定是比英伟达有差距的;第二个原来在英伟达应用很熟练,就像我们用苹果手机用得很熟练,就不愿意转过来,它是工程师的习惯问题,而不是高层的问题。虽然芯片供应问题阻碍了昇腾生态发展,但生态是用出来的,只要大家心往一处想,都来使用,国内生态一定会发展起来。”徐直军表示。

富深所提示:文章来自网络,不代表本站观点。

- 上一篇:配资门户平台 何以中国 黄河安澜丨大河之畔绘文明生态新长卷

- 下一篇:没有了